- 긴 말 필요없이 정의부터. convex function의 정의는 다음과 같다.

- 특정 구간의 범위 a,b에서 이 구간에 속하는 x1, x2에 대해서, x1~x2 사이에 있는 f(x1) ~ f(x2)의 모든 값이

λf(x1) + (1- λ) f(x2) 사이의 직선 아래에 존재한다는 것이다.

- f가 concave함수라면, -f는 convex 함수이다. convex funciton always lies below any chord and concave function always lies above any chord.

- strictly convex는 2.72의 수식에서 밑의 = 기호만 빼면 된다.

- 이 그림을 참조하면 좋을 것 같다.

- 관련 성질은 추가적으로 덧붙여 봤는데,

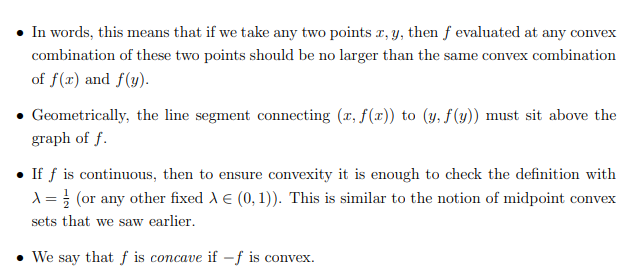

1. 즉, 우리가 임의의 두 점 x, y를 취하면, 이 두 점의 어떤 convex한 함수 f에서 평가된 f(x)와 f(y)의 동일한 볼록한 조합보다 크지 않아야 한다.

2. 기하학적으로 (x, f(x))에서 (y, f(y))를 잇는 선분은 f 의 그래프 위에 있어야 한다

3. 만약 f가 continuous하다면, 즉, 연속이라면 λ=0.5 일 때만 평가해도 충분하다.

4. f가 concave (볼록함수이면), -f는 오목함수이다.

- 예시로는 다음과 같은 함수들이 있다.

- Strongly convex라는 용어가 등장하는데, 여기서 의미하는 Strongly convex function은 0보다 큰 a가 ∃, 존재할 때,

f(x) - α||x||_2 가 convex한 경우이다.

- 여기서 α||x||_2는 euclidean norm이라고 불리는 L2 Norm이다.

- 흠.. 이게 왜 Strongly convex한지는 Convex optimization 시간에 알아보자. 왜냐하면 지금은 정보이론 시간이니까..

- 더 관심이 있다면, 이 링크에서 보자. [Princeton Convex and Conic Optimization week 7]

- 조금 요약을 하자면, 하나의 Globam minima를 가지고 최적화를 할 수 있다 라고 해야할까?

- 증명은 위의 수식과 같다. 우리는이 함수가 볼록함수임을 바탕으로 2차 미분 계수가 0보다 큼을 보일 수 있다.

- 그리고 테일러 급수를 통해 x1, x2에서 이를 전개하면 된다.

- 우리는 2차미분계수까지만 구하면 되기에, 2차 미분계수의 값은 라그랑주의 중간값 정의를 활용해서 전개하면 된다.

- 라그랑주의 중간값 정리- 테일러 급수에서 나머지 항에 대해 x*가 x0~x사이에 존재한다는 이론이다.

- 그리고 이 f''(x*) >= 0 임을 보일 수 있기에, 우리는 앞의 두 항만 처리하면 된다.

- x0은 앞서서 본 것처럼, λ를 가지고 x1과 x2의 합으로 정의할 수 있다.

- 그리고 각각의 x=x1, x=x2를 위의 테일러 급수에 넣어서 수식을 전개하면 2.72 수식을 얻을 수 있다.

- 구체적인 전개는 아래 수식참고.

2-6-2 Jensen's inequality

- Jensen's inequality는 다음과 같다. 기댓값의 함수값이, 확률 변수의 함수 값 f(X)의 기댓값보다 작다는 것을 의미한다.

- 만약 f가 Strictly convex하다면, Ef(X) = f(EX) 일 것이며, 이때 EX = X이고, 이를 만족시키기 위해서는 X는 상수값을 가진다.

- convex function f와 두개의 확률 질량 분포가 존재할 때, 위와 같은 수식을 만족함을 볼 수 있으며

- 이 증명을 보면, 수학적 귀납법을 통해 이를 증명한다. 우선 k-1개의 point에 대해 젠센 부등식이 성립함을 보여주며, (2.78) 이를 바탕으로 새로운 k번째 point에 대해서도 젠센 부등식이 성립함을 보여주며, convex function f에 대한 확률 변수 X는 젠센 부등식을 만족함을 보여준다.

- 그리고 2.6.3 Theorem으론 Information inequality이다. 두 개의 확률 질량 함수 p, q에 대해서 Distance를 구하는

Kulbeck-Leibler divergence를 구할 때도 최소 값은 0이라는 것이다. KL divergence의 정의에서도 나오지만, 두 확률 질량 함수의 최소 거리는 둘이 같을 때인 0이다.

- 증명은 다음과 같다. 2.84에서 2.85로 넘어갈 때, Convex함수인 log함수에 대해 Jensen inequality를 적용하면 된다.

- 또한 Mutual information의 정보량 또한 0보다 크다.

- 증명은 위의 2.82와 같이 하면 되기에 따로 하지는 않겠다

- 또한 Mutual information을 구하는 과정에서 나오는 D(p(x,y) || p(x)p(y)) >= 0 에 의해 위의 수식 만족

- 마찬가지로, I(X;Y|Z) >= 또한 0보다 크다.

- 그리고 H(X)는 log |X| 보다 작거나 같은 수식이 있는데, 여기서 X는 x의 크기 이다. 따라서, 정보이론에서의 정보를 압축할 때, 압축된 정보의 평균 비트 수 H(X)는 log |X| 보다 작아야 한다는 것을 의미한다.

- 그리고 Information can't hurt라는 Conditioning reduces entropy의 수식이다.

- 이 뜻은, 정보를 결국 더하는 것은 불확실성을 최소한 유지한다는 뜻이지 해가 되지 않는다는 뜻이다.

- 증명은 위와 같다.

- 또한 Independence bound on entropy의 수식은, 여러개 Entropy의 Joint distribution은 각각의 Entropy를 합한 것 보다 낮다 라는 것이다.

- 확률변수들이 서로 독립적인 경우에는, 결합 엔트로피는 개별 엔트로피의 합과 같다. (등호 성립)

- 앞서서 본 Conditioning reduces entropy와 유사하게, 확률변수들 사이에 어떤 종류의 의존성이 있을 경우 (여러개의 Entropy 혹은 정보를 결합해서 구할경우), Joint 엔트로피는 개별적으로 Sigma를 통해 구해지는 엔트로피의 합보다 작다. - 이는 확률변수들 사이의 추가 정보가 없기 때문에, 정보의 총량이 감소한다는 것을 의미.

'Information Theory' 카테고리의 다른 글

| 7-4 PREVIEW OF THE CHANNEL CODING THEOREM (2) | 2023.12.03 |

|---|---|

| 7.2 7.3 SYMMETRIC CHANNELS, PROPERTIES OF CHANNEL CAPACITY (1) | 2023.12.01 |

| 7-1. CHANNEL CAPACITY (2) | 2023.11.30 |

| Chapter 2-3, 2-4, 2-5, RELATIVE ENTROPY, MUTUAL INFORMATION + CHAIN RULE (0) | 2023.11.19 |

| Chapter 2-1, 2-2, ENTROPY | Information Theory. (0) | 2023.11.18 |